ニュース(2006/11/6更新)

| 掲載日 | タイトル |

| 06/11/6 | 世界最高速のスーパーコンピュータ用プロセッサチップ開発に成功 |

| 05/5/4 | 日本の研究チームがインターネット速度記録を更新 |

| 04/11/15 | インターネット通信性能で世界最高を達成 |

| 04/10/20 | 世界最長の10ギガビットイーサネットネットワークが東京とCERN 研究所 (在スイス) 間で米国、カナダ、オランダの研究ネットワーク連合により実現 |

| 04/05/26 | 世界最高速のコンピュータ開発プロジェクトがスタート |

インターネット通信性能で世界最高を達成

2004年11月15日 ─ 東京大学とWIDEプロジェクトの研究者が日本、カナダ、米国、オランダと CERN 研究所(スイス・ジュネーブ)の研究者との協力により、米国ピッツバーグから日本を経由してスイス・ジュネーブまでの世界最長の10ギガビット回線を構築し、ピッツバーグの SC2004 国際会議会場に設置された東京大学のシステムから CERN 研究所に設置された東京大学のシステム間を接続し、TCP による高速通信実験を実施しました。ネットワークの全長は約 31,248 Km あり、17 のタイムゾーンを通過しています。

実験では、一個の TCPストリームだけを用いて、7.21 ギガビット/秒のデータ転送を実現しました。データ転送は1500バイトの標準イーサネットフレーム長を用い、20分間行いました。

この国際協調プロジェクトは、研究と教育における国際ネットワーキングの世界を拡大し、新しい国際共同研究の基礎となるものです。

概要

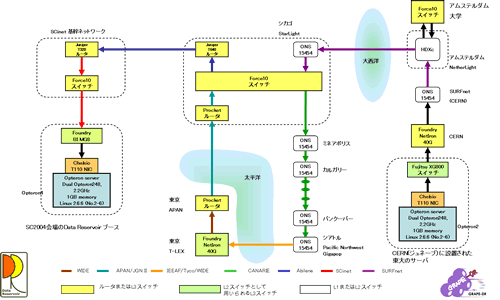

今回実現したネットワークは、10 Gigabit イーサネット WAN PHY 技術とOC-192POS技術を組み合わせて用いることにより、CERN 研究所の計算機とピッツバーグの計算機を直結しています。ピッツバーグの SC2004 国際会議会場に設置された東京大学の計算機から、SC2004 国際会議会場ネットワークである SCinet を経由し、Abilene によりシカゴの StarLight を経由してAPAN/JGN2 ネットワークで東京に到達し、WIDE Project が運用する T-LEX に接続し、T-LEX から米国シアトルまでは TycoTelecommunication が IEEAF に寄贈した回線が用い、Pacific NorthwestGigapop の機器に接続しました。シアトルからは、回線は CA*net4 の専用のラムダによってシカゴの StarLight まで運ばれました。StarLight では SURFnet のシカゴ─アムステルダム間のラムダに接続されて、アムステルダムの NetherLight に接続されました。NetherLight と CERN 研究所の間は、SURFnet のアムステルダム─ジュネーブのラムダによって接続されています。(図1)

|

| 図1 |

単一ストリームのTCP転送実験は、1組のChelsio T110 10Gigabit イーサネットインタフェースカードを実装したAMD Opteronプロセッサを用いたサーバ間で実施され、7.21Gbps

の実質データ転送速度を得ました。実験で用いたパケット長は、イーサネット標準パケット長である1500バイトです。ネットワークにおけるバンド幅・距離積は

225,298 テラビット メートル/秒です。実現したデータ転送速度を用いると、1台のパソコンと1枚のネットワークカードを用いて、DVD一枚が約5.5秒で世界の何処にでも転送できる速度であることを意味しています。

7.21Gbpsの長距離データ転送速度は、標準パケット長を用いたTCPシングルストリームの転送速度として世界最高速である 225,298

テラビット メートル/秒のバンド幅・距離積であり、従来の記録 ( Internet Land Speed Record )の 124,935

テラビット メートル/秒を80%越しています。

また、データレゼボワールシステムは、1 台の Opteron サーバを使用することにより、1.6Gbps のディスク間転送を達成しました。これは、200MB/sの能力を持つサーバが容易に実現できたことを示しました。

この高速TCP通信技術は、東京大学のデータレゼボワール/GRAPE-DR プロジェクトにより、長距離高バンド幅ネットワークにおける大量データの TCP 通信の最適化研究やデータ共有システム研究に用いられます。TCP技術は、科学技術データの転送だけでなく、インターネットを用いたウェブページアクセスや、音楽・画像ファイル転送に広く用いられている方法であるため、高速TCPの実現は、より地球を更に狭くする情報化社会の実現に貢献します。

なお、本実験はSC2004国際会議におけるバンド幅チャレンジの一環として実施し、シングルストリームTCP通信において世界記録を達成したことにより Land Speed Record 賞を受賞しました。本プロジェクトは本賞を3年連続で受賞しています。

なお、本成果は、科学技術振興調整費「重要課題解決型研究等の推進」プログラムの実施課題「分散共有型研究データ利用基盤の整備」によるものです。本実験をサポートして頂いた NTT コミュニケーションズ、東京大学情報基盤センターに感謝します。

この実験は、次の企業による機材の提供やサポートを得て実現されました:

Foundry Networks、Juniper Networks、物産ネットワークス、およびネットワンシステムズ。

![]()

連絡先

- 東京大学大学院情報理工学研究科コンピュータ科学専攻 教授

- 平木 敬

- e-mail:hiraki@is.s.u-tokyo.ac.jp

- 電話:03-5841-4039

実験参加者

- 東京大学

- 平木 敬、稲葉真理、中村 誠、玉造潤史、青嶋奈緒、西村 亮

- ㈱富士通コンピュータテクノロジーズ

- 来栖竜太郎、坂元眞和、古川裕希、生田祐吉

- WIDEプロジェクト

- 加藤 朗、山本成一

- NTTコミュニケーションズ

- 長谷部克幸、村上満雄、根尾美由紀

- チェルシオ・コミュニケーションズ(米国)

- Felix Marti、Wael Noureddine

ネットワーク担当機関

- APAN

- JGN2

- IEEAF

- Tyco Telecommunications

- Northwest Giga Pop

- CANARIE

- StarLight

- SCinet

- SURFnet

- SARA

- Pieter de Boer

- University of Amsterdam

- Cees de Laat

- Paola Grosso

- Freek Dijkstra

- CERN

- Catalin Meirosu

![]()

東京大学データレゼボワール/GRAPE-DR プロジェクトは文部科学省科学技術振興調整費に基づいた研究プロジェクトで、科学技術データの国際的な共有システムの構築および天文学や物理学、生命科学のシミュレーションを実施する高速計算エンジンの実現を目指しています。GRAPE-DR プロジェクトでは 2008 年に 2PFLOPS の計算エンジンと数 10Gbps のネットワークを利用する国際的な研究基盤を構築します。詳細は

http://data-reservoir.adm.s.u-tokyo.ac.jp/ および http://grape-dr.adm.s.u-tokyo.ac.jp/ をご覧下さい。連絡先は平木敬教授 hiraki@is.s.u-tokyo.ac.jp, です。

WIDE Project は、インターネットに関連する各種技術の実践的な研究開発を行う研究プロジェクトであり、1988 年から活動を行っています。133 の企業と 11 の大学を含む他の沢山の組織と連携して、インターネットの様々な発展に寄与してきました。Root DNS サーバの一台である M.ROOT-SERVERS.NET の運用を 1997 年から行っており、また IEEAF 太平洋リンクのホストとしてT-LEX (http://www.t-lex.net/) の運用も行っております。詳細はhttp://www.wide.ad.jp/ をご覧下さい。連絡先は、press@wide.ad.jp (Tel:0466-49-3618, Fax: 0466-49-3622)です

APANは、1997年6月に東京でコンソーシアムを設立、同年12月にネットワークの構築を開始し、 翌年9月には米国政府機関NSFから研究資金も受領して、対米リンク (TransPAC)の運用も始めた国際研究ネットワークです。その後も研究・教育ネットワークの参加が相次ぎ、APANはアジア域内のほぼ全ての研究・教育ネットが結集するコンソーシアムに成長、アジア域内の運用センター機能を提供すると共に、北米やヨーロッパと連携してグローバルな研究・教育ネットワークを構成、先端的国際共同研究を進めています。

JGN2は、1999年4月から2004年3月まで運用されたJGN(Japan Gigabit Network:研究開発用ギガビットネットワーク) を発展させた新たな超高速・高機能研究開発テストベッド・ネットワークとして、独立行政法人情報通信研究機構(以下、「NICT」)が2004年4月から運用を開始したオープンなテストベッド・ネットワーク環境です。産・学・官・地域などと連携し、次世代のネットワーク関連技術の一層の高度化や多彩なアプリケーションの開発など、基礎的・基盤的な研究開発から実証実験まで推進することを目指しています。

JGN2は、全国規模のIPネットワーク、光波長ネットワーク、光テストベッドの研究開発環境を提供しています。また、2004年8月から日米回線を整備し、国内外の研究機関とも連携して研究開発を推進しています。

CANARIE はカナダの先端インターネットの非営利組織で、次世代研究ネットワークやそのアプリケーション、サービスを促進しています。主要なメンバーや世界中の同様な組織との協調を促進することによって、CANARIE は技術革新と成長を促し、社会的、文化的、経済的な利点をカナダ国民にもたらすことに貢献します。CANARIE はカナダを先進ネットワークで世界のリーダと位置づけ、メンバーやプロジェクトパートナー、カナダ政府によってサポートされています。CANARIE はカナダの研究教育ネットワークである CA*net4 の開発および運用を行っています。詳しくは http://www.canarie.ca/ をご覧下さい。

CERN 研究所は素粒子物理のヨーロッパの研究所で、基礎研究センターとして世界的に著名な研究所の一つで、LHC (Large Hadron Collider) 加速器を現在建設中です。LHC は、これまでで最も野心的な科学プロジェクトで、微小な粒子を正面衝突させることにより自然界の基本法則を解明しようとするものです。2007 年に稼働開始予定で、世界中の大学や研究所の約 7,000 人の研究者が、この加速器を利用して科学の最も根元的な疑問の幾つかに解答を与えようとしています。詳細は http://www.cern.ch/ をご覧下さい。

Pacific Northwest Gigapop はアメリカ北西部に於ける次世代インターネットの基盤で、アプリケーションの協調やテストベットであり、国際的な peering 交換地点である Pacific Wave を運用し、また WIDE と協調して IEEAF 太平洋回線の運用を行っています。PNWGP と Pacific Wave は共に広帯域な国際および国内のネットワークを、ワシントン、アラスカ、アイダホ、モンタナ、オレゴンの各州や太平洋地域の大学や研究機関、先端的な R&D やニューメディア企業へと接続しています。詳細は http://www.pnw-gigapop.net/ をご覧下さい。

SURFnet はオランダの 150 を越える高等教育機関や研究所を接続しているネットワークの運用と開発を行っており、国際的な先端的な研究ネットワークの一つです。SURFnet は、オランダ通商産業省、教育機関、研究機関のプロジェクトである次世代ネットワーク Gigaport の実現に責任を持っており、国内の知識基盤の強化を図ります。光および IP ネットワークやグリッドはプロジェクトの主要な要素です。詳細は http://www.surfnet.nl/ をご覧下さい。

IEEAF (Internet Educational Equal Access Foundation) は通信帯域や機材の寄贈を受け、国際的な研究教育コミュニティに提供することを目的とした非営利組織です。IEEAF 太平洋回線は Tyco Telecom によって5年間の IRU として寄贈された二番目の 10Gbps の海底ケーブルによる回線です。最初の回線である IEEAF 大西洋リンクはニューヨークとオランダのグローニガンを接続しており、2002 年から運用されています。IEEAF の寄贈は現在 17 のタイムゾーンに跨っています。詳細は http://www.ieeaf.org/ を参照して下さい。

チェルシオ・コミュニケーションズ(本社:米国カリフォルニア州)は10ギガビット・イーサネットのネットワークインタフェースカードと、プロトコルプロセッサ技術を開発し、実験で用いたT110 10ギガビットイーサネットプロトコルエンジンを製造・発売しています。

SCinet は、SC2004国際会議の展示場において最先端のネットワークを提供する組織で、全世界のネットワーク組織から集められた技術者により運営されています。

用語解説

- インターネット

- 広義では、多数のユーザにより共有して使われ、国内・海外のネットワーク通信を実現しているネットワークを意味するが、通常は、ウェブページアクセス、メール、ファイル転送などに広く用いられているTCPを用いたネットワーク体系のことである。

- TCP

- Transmission Control Protocolの略。ネットワーク上では、エラーの発生、複数の通信の衝突による利用可能バンド幅の減少と不安定性が問題である。これを解決するため、受信側が送信側に正常に受理した確認(アクノレッジ)を返すことにより、送信側が正常に通信が行われたことを確認するとともに、次に送る流量を決定する通信プロトコル。正常なアクノレッジが返らなかった場合には、データの再送により信頼ある通信を実現する。

- Internet Land Speed Record

- インターネットを用いたデータ転送能力を、バンド幅 距離積で評価し、その最高記録である。米国Internet2で認定する。カテゴリーは、IPv4, IPv6について、TCPの単一ストリームと複数ストリームのクラスに分けられる。今回は、IPv4のTCP単一ストリームおよび複数ストリームのカテゴリーに対応する実験である。詳細は http://lsr.internet2.edu/

- OC-192 POS技術

- 超高速光通信の方式の一つ。光通信の国際標準規格であるSONET上に、直接IPパケットを載せることにより実現する。OC-192は、9.6Gbpsの帯域幅を持つ。現在、国内外の幹線に用いられ始めている。

- WAN PHY技術

- 超高速光通信の最新技術。上記光通信の規格であるSONET上に、イーサネットのパケットを直接載せる方式。WAN PHY技術を用いることにより、通常用いられているイーサネットをそのまま国内外の大域ネットワークとして拡張可能になる。また、OC-192 POS技術と比較して、安価な実現が可能であり、またLANのスイッチを共用できる場合があるため、安価な長距離光通信実現技術として注目されている。

- SC2004

- スーパーコンピューティングと、超高速ネットワークに関する国際会議。毎年11月に開催され、この分野では最も高い権威を持っている。東京大学データレゼボワールプロジェクトは、2002年と2004年に論文発表を行った。2004年には、データレゼボワールプロジェクト以外では、JAXAによる流体シミュレーションに関する発表、JAMSTECによる地球シミュレータを用いた高速地球シミュレーションが行われた。全体では59件の論文が採録された。

- バンド幅チャレンジ

- SC2004に併設して実施される高速ネットワーク利用に関するコンテスト。高速ネットワークを以下に高速、かつ科学技術に有意義に用いたかで競われる。データレゼボワールプロジェクト・GRAPE-DRプロジェクトチームは、2002、2003年に引き続き、3年連続で受賞した。

世界最長の10ギガビットイーサネットネットワークが

東京とCERN 研究所 (在スイス) 間で米国、カナダ、オランダの

研究ネットワーク連合により実現

概要

2004年10月18日 ─ 日本、カナダ、米国、オランダと CERN 研究所(スイス・ジュネーブ)の研究者が共同して、日本からスイスまでの世界最長の10ギガビットイーサネット回線を構築し、東京大学に設置されたデータレゼボワールシステムから CERN 研究所に設置されたデータレゼボワールシステム間を接続しました。ネットワークの全長は約 18,500Km あり、17 のタイムゾーンを通過しています。

この国際協調プロジェクトは、研究と教育における国際ネットワーキングの世界を拡大し、新しい国際共同研究の基礎となるものです。

今回実現したネットワークは、10Gigabit イーサネット WAN PHY 技術を用いることにより、東京大学の計算機を CERN 研究所の計算機と恰も同一 LAN 上であるかのように接続を行っています。東京大学から WIDE Project が運用する T-LEX まで接続し、T-LEX から米国シアトルまでは TycoTelecommunication が IEEAF に寄贈した回線が用いられ、Pacific NorthwestGigapop の機器に接続されました。シアトルからは、回線は CA*net4 の専用のラムダによってシカゴの StarLight まで運ばれた。StarLight では SURFnet のシカゴ─アムステルダム間のラムダに接続されて、アムステルダムの NetherLight に接続されました。NegherLight と CERN 研究所の間は、SURFnet のアムステルダム─ジュネーブのラムダによって接続されています。

今回実現したネットワークは、10Gigabit イーサネット WAN PHY 技術を用いることにより、東京大学の計算機を CERN 研究所の計算機と恰も同一 LAN 上であるかのように接続を行っています。東京大学から WIDE Project が運用する T-LEX まで接続し、T-LEX から米国シアトルまでは TycoTelecommunication が IEEAF に寄贈した回線が用いられ、Pacific NorthwestGigapop の機器に接続されました。シアトルからは、回線は CA*net4 の専用のラムダによってシカゴの StarLight まで運ばれた。StarLight では SURFnet のシカゴ─アムステルダム間のラムダに接続されて、アムステルダムの NetherLight に接続されました。NegherLight と CERN 研究所の間は、SURFnet のアムステルダム─ジュネーブのラムダによって接続されています。

また、データレゼボワールシステムは、9 台の Xeon サーバをそれぞれ使用することにより、9Gbps のディスク間転送を達成しました。国際的なディスク間転送においては、この数字は以前は達成されていなかったものです。

このネットワークの構築には、Foundry Networks、Nortel Networks および Cisco Systems を含む様々なベンダのネットワーク機器が用いられました。この実験は、これらのベンダーによる 10Gigabit イーサネット WAN PHY や、光を用いたSONET/SDH機器の相互運用による世界初めてのネットワーク構築です。

この 10Gigabit イーサネットは、東京大学のデータレゼボワール/GRAPE-DR プロジェクトにより、長距離高バンド幅ネットワークにおける大量データの TCP 通信の最適化研究やデータ共有システム研究に用いられます。CERN 研究所が現在建設中の LHC 加速器(Large Hadron Collider)を用いる ATLAS 実験において、東京大学は日本におけるデータ解析センターとして寄与する予定で、このような大量データの長距離転送は重要な意味を持つことになります。データ転送は東京大学と CERN 研究所にそれぞれ設置されたデータ共有システムであるデータレゼボワールシステムの間で行われれました。Chelsio T110 10Gigabit イーサネットインタフェースカードを実装した2台のサーバ間で単一TCPプロトコルを用い、イーサネット標準である1500バイトフレームを用いて平均 7.57Gbps のデータ転送を達成しています。

このネットワーク実験は、現在構築中の GLIF (Global Lambda Integrated Facility) の協力とサポートによるものです。この実験の多くの参加者はGLIF にも参加しています。

この実験は、次の企業による機材の提供やサポートを得て実現されました:Foundry Networks、Nortel Networks、Chelsio Communications、Cisco Systems, 物産ネットワークス、およびネットワンシステムズ。

また、本実験をサポートして頂いた EUプロジェクト ESTA (IST-2001-33182)、CERN OpenLAB、SARA、Global Crossing、Industry Canada、NTT コミュニケーションズ、東京大学情報基盤センター、および文部科学省科学技術振興調整費に感謝します。

CANARIE はカナダの先端インターネットの非営利組織で、次世代研究ネットワークやそのアプリケーション、サービスを促進しています。主要なメンバーや世界中の同様な組織との協調を促進することによって、CANARIE は技術革新と成長を促し、社会的、文化的、経済的な利点をカナダ国民にもたらすことに貢献します。CANARIE はカナダを先進ネットワークで世界のリーダと位置づけ、メンバーやプロジェクトパートナー、カナダ政府によってサポートされています。CANARIE はカナダの研究教育ネットワークである CA*net4 の開発および運用を行っています。詳しくは http://www.canarie.ca/ をご覧下さい。

CERN 研究所は素粒子物理のヨーロッパの研究所で、基礎研究センターとして世界的に著名な研究所の一つで、LHC (Large Hadron Collider) 加速器を現在建設中です。LHC は、これまでで最も野心的な科学プロジェクトで、微小な粒子を正面衝突させることにより自然界の基本法則を解明しようとするものです。2007 年に稼働開始予定で、世界中の大学や研究所の約 7,000 人の研究者が、この加速器を利用して科学の最も根元的な疑問の幾つかに解答を与えようとしています。詳細は http://www.cern.ch/ をご覧下さい。

Pacific Northwest Gigapop はアメリカ北西部に於ける次世代インターネットの基盤で、アプリケーションの協調やテストベットであり、国際的な peering 交換地点である Pacific Wave を運用し、また WIDE と協調して IEEAF 太平洋回線の運用を行っています。PNWGP と Pacific Wave は共に広帯域な国際および国内のネットワークを、ワシントン、アラスカ、アイダホ、モンタナ、オレゴンの各州や太平洋地域の大学や研究機関、先端的な R&D やニューメディア企業へと接続しています。詳細は http://www.pnw-gigapop.net/ をご覧下さい。

SURFnet はオランダの 150 を越える高等教育機関や研究所を接続しているネットワークの運用と開発を行っており、国際的な先端的な研究ネットワークの一つです。SURFnet は、オランダ通商産業省、教育機関、研究機関のプロジェクトである次世代ネットワーク Gigaport の実現に責任を持っており、国内の知識基盤の強化を図ります。光および IP ネットワークやグリッドはプロジェクトの主要な要素です。詳細は http://www.surfnet.nl/ をご覧下さい。

東京大学データレゼボワール/GRAPE-DR プロジェクトは文部科学省科学技術振興調整費に基づいた研究プロジェクトで、科学技術データの国際的な共有システムの構築および天文学や物理学、生命科学のシミュレーションを実施する高速計算エンジンの実現を目指しています。GRAPE-DR プロジェクトでは 2008 年に 2PFLOPS の計算エンジンと数 10Gbps のネットワークを利用する国際的な研究基盤を構築します。詳細は

http://data-reservoir.adm.s.u-tokyo.ac.jp/ および

http://grape-dr.adm.s.u-tokyo.ac.jp/ をご覧下さい。

連絡先は平木敬教授 <hiraki@is.s.u-tokyo.ac.jp>

電話:03-5841-4039(平木)

FAX: 03-3818-1073

です。

WIDE Project は、インターネットに関連する各種技術の実践的な研究開発を行う研究プロジェクトであり、1988 年から活動を行っています。133 の企業と 11 の大学を含む他の沢山の組織と連携して、インターネットの様々な発展に寄与してきました。Root DNS サーバの一台である M.ROOT-SERVERS.NET の運用を 1997 年から行っており、また IEEAF 太平洋リンクのホストとしてT-LEX (http://www.t-lex.net/) の運用も行っております。詳細は

をご覧下さい。連絡先は、 (Tel:0466-49-3618, Fax: 0466-49-3622)です。

IEEAF (Internet Educational Equal Access Foundation) は通信帯域や機材の寄贈を受け、国際的な研究教育コミュニティに提供することを目的とした非営利組織です。IEEAF 太平洋回線は Tyco Telecom によって5年間の IRU として寄贈された二番目の 10Gbps の海底ケーブルによる回線です。最初の回線である IEEAF 大西洋リンクはニューヨークとオランダのグローニガンを接続しており、2002 年から運用されています。IEEAF の寄贈は現在 17 のタイムゾーンに跨っています。詳細は http://www.ieeaf.org/ を参照して下さい。

GLIF は先端的な科学技術の協力や発見のため、自発的に光ネットワークの資源や経験を共有するための研究所、組織、コンソーシムおよび各国の研究ネットワークからなる連合体で、SURFnet およびオランダのアムステルダム大学のリーダシップにより活動しています。詳細は http://www.glif.is/ をご覧下さい。

世界最高速のコンピュータ開発プロジェクトがスタート

| 連絡先: | 東京大学大学院情報理工学系研究科 平木 敬 e-mail: hiraki@is.s.u-tokyo.ac.jp |

| 東京大学大学院理学系研究科 牧野淳一郎 email:makino@astron.s.u-tokyo.ac.jp |

キーポイント

2008年に2ペタフロップス、40Gbpsネットワーク基盤との結合、多様なアプリケーションプログラムによる科学技術的成果の実現

概要

東京大学、情報通信研究機構、NTTコミュニケーションズ、国立天文台、理化学研究所による研究グループ(代表者:平木 敬 東京大学大学院情報理工学系研究科教授)の超高速計算システム研究開発プロジェクトであるGRAPE-DRプロジェクト(課題名:分散共有型研究データ利用基盤の整備)は平成16年度科学技術振興調整費に採択され、研究開発を開始する。GRAPE-DRプロジェクトは、2008年に2ペタフロップスの計算速度を実現するとともに、40Gbpsネットワークを高度利用した科学技術研究データ処理システムを構築する。

現在実施されている国内,海外の超高速計算システムプロジェクトでは、GRAPE-DRプロジェクトが最も早期にペタフロップスを越す予定である。(注1)

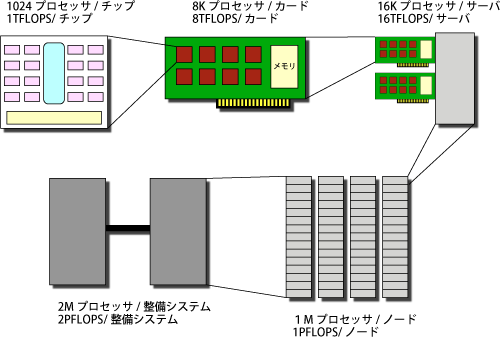

GRAPE-DRは200万個の演算プロセッサをラック10本以下のサイズに超高密度に集積することにより、2ペタフロップスの計算速度を達成し(注2)、高集積のIPディスク技術により、ネットワークとファイルシステムを実現する。(注3)

プロジェクトのホームページ http://grape-dr.adm.s.u-tokyo.ac.jp

| 注1) | 日本におけるプロジェクト: | 地球シミュレータ(2002年)40 TFLOPS(既設)),GRAPE-6(64TFLOPS, 2001, (既設)),NAREGIクラスタコンピュータによるグリッド(100 TFLOPS, 2007年) |

| 海外のプロジェクト: | BlueGene(360 TFLOPS,2005年,米国IBM),ASCI-Purple(100 TFLOPS, 2005年,米国ロスアラモス国立研究所),CRAY X1他(50 TFLOPS, 2005年末,米国オークリッジ国立研究所),PERCS (1PFLOPS, 2008年,米国IBM),Hero(1PFLOPS, 2008年,米国サンマイクロシステムズ),Cascade(1PFLOPS, 2010年,米国CRAY) | |

| 注2) | 2ペタフロップスの計算速度は,現在,世界最速である地球シミュレータの50倍の計算速度である.1秒間に2000兆回の計算を行う. | |

| 注3) | IPディスク技術とは,コンピュータとディスクとの間を専用バス(SCSIバス,ファイバチャネルなど)ではなく,一般のIPネットワーク(例えばイーサネット)で結合する技術.入出力ネットワークとストレージネットワークを統合することにより,データ共有が高効率で実現する. | |

1.提案の概要

近年の急速な計算速度,ネットワーク速度と記憶容量(メモリ,ディスク)の増大に支えられ,高速インターネットで接続したコンピュータシステム群は,科学技術の研究基盤としてなくてはならないものとなった.GRAPE-DRプロジェクトの開始時点である2004年では,10Gbpsのネットワークが普及し,欧米では科学技術用インターネット・バックボーンは数10Gbps以上となり各地のスーパーコンピュータセンターにおいてコンピュータやストレージとの接続性が確保されている.また,科学技術計算の速度では,我が国のGrape-6(64TFLPS)と地球シミュレータ(40TFLOPS)を頂点に,1 TFLOPSを越すことが常識化しつつある(www.top500.orgによると,1TFLOPSは131位).このような情報基盤を如何に有効に活用できるか,情報基盤の持続的な進化を如何に実現するかは,今後の我が国の科学技術研究ポテンシャルにとり,本質的な重要性を持っている.

GRID技術は,ネットワークにより分散したコンピュータ資源,ストレージ資源を,場所を意識せずに使うことを目標として,1990年代の後半から盛んに研究開発が行われ,我が国へも導入されつつある.しかしながら,ミドルウェアを中心としたGRID技術は,期待は大きいものの実際の研究の現場ではGRID自身が研究テーマでない限り,殆ど使われていないのが現状である.一方,高い計算能力を低コストで得るための手法としてのクラスタ計算機は,現実的に設置可能なサーバ台数の限界から汎用MPUを用いるだけでは100TFLOPSを越す性能の達成は困難であり,次世代の科学技術研究のための情報基盤として性能面での限界を持つ.

GRAPE-DRプロジェクトは,上記問題点を克服し,科学技術研究の現場で,高速インターネット,コンピュータシステムと大容量ストレージの持つ能力を世界最高の性能レベルで活用する情報システム基盤を構築することを目的とする.具体的には,ネットワークで接続されたシステムの集合体によって,(1) 科学技術データの分散共有(データ転送を含む),(2) 分散透明性を持ち,超高速の計算能力と,(3) 科学技術データに対す分散的超高速データベース処理(複雑データの探索,発見的データベース処理等)を実現する.すなわち,研究者が今まで手にすることが出来なかったレベルの情報サービスを,計算機科学以外の分野の研究者から実用的に使える形で提供することである.

1Gbpsのネットワーク,100GFLOPSのPCクラスタ,1テラバイトのストレージが容易に入手できる今日,科学技術研究の現場で研究基盤として成立するためには,少なくとも,(1) 通常のサーバ・ミドルウェアでは実現できない100Gbpsレベルの超高速ネットワーク、PFLOPSレベルの超高速計算能力と、それらをスケーラブルに高効率利用が可能なデータの分散共有能力,さらに遠隔地間に分散した多量データ全体に対し,超高速のデータベース処理能力が備わっていることが必要であり,それらを実現することがGRAPE-DRプロジェクトの具体的目的である.

2.2ペタフロップス実現の方法

単一プロセッサの性能の限界を超す超高速計算システム構築は必然的に並列・分散アーキテクチャを用いることが必要であり,現在実施されている全ての超高速計算システムプロジェクトは並列・分散アーキテクチャを採用している.

しかしながら,ペタフロップスを越す性能を持つシステムの実現には,(1)設置面積,(2)消費電力(3)ユーザが得られる実質的性能(実行効率),および(4)システムの信頼性が困難な課題として現出する。例えば,現在主流である汎用プロセッサを用いた汎用サーバを多数個結合するクラスタコンピュータまたは,それを分散的に結合したGridシステムではペタフロップスを越すシステムの実現は困難である(注4).すなわち,科学技術の研究の現場が求めている計算システムは(1)小型,(2)低消費電力,(3)高実行効率で(4)研究者が直接使える信頼性を持つことが強く求められる.

GRAPE-DRシステムはこの困難な課題をGRAPEシリーズのコンピュータ開発(注5)で培われた超並列計算方式を汎用化し,プロセッサの超高集積化とストレージのIP化による超分散化により実現する.具体的には

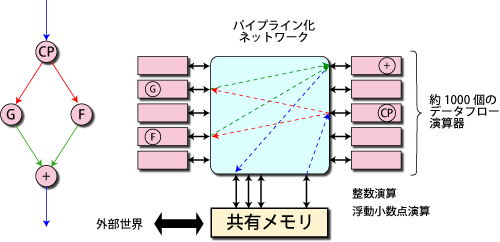

- 1チップに1024プロセッサを集積.

- 新アーキテクチャの採用により,プロセッサ間を直接パイプライン・ネットワークで結合することによる超低遅延時間のプロセッサ間データ転送の実現(10ナノ秒以下)(注6)

- ラック8本に100万プロセッサを高密度実装することによる,面積・電力の低減

- 超低遅延時間のネットワーク結合が実現する高並列実行効率

- IPストレージ(iSCSIプロトコルによる)の超高速実現による,分散共有ストレージの利用

- データレゼボワール技術(注7)の拡張による超高速ネットワークの高度利用

- 小型で低消費電力の実現による高信頼化

が基本技術である.

| 注4) | 現在建設中の世界最高速クラスタであるASCI-Purpleシステムでは,1個のノードが8 GFLOPSの演算性能を持つ。サイズ,消費電力をプロセッサあたり1Uサイズ,200ワットと仮定するとプロセッサ部分だけで312ラック(高さ40Uラック換算),2.5メガワットの電力が必要である。今後数年間で,プロセッサの演算性能が2倍向上すると仮定しても,1ペタフロップスの実現には1560ラック,125メガワットの消費電力が必要となり,実現が非常に困難であるとともに,信頼性の低下が予想される. また,クラスタシステム間を超高速ネットワークで接続するGrid的形態では,クラスタ内の通信遅延時間が数マイクロ秒,クラスタ間の通信遅延時間が数ミリ秒となり,1個のプロセッサの演算時間と比較し,クラスタ内で数千倍,クラスタ間では数100万倍の通信遅延である.従って,1個のプログラムが内包する並列性を有効に利用することが著しく困難である.その結果,クラスタ計算機,特にGrid的形態ではプロセッサ相互通信が非常に少ない自明並列性の利用が主に使われる使用形態であることが現状である. |

| 注5) | GRAPEシリーズの天体シミュレーション専用コンピュータは,本研究開発担当者の一人である牧野淳一郎により開発され,惑星生成・銀河生成分野において多くの成果を挙げている.GRAPEシリーズは,世界最高速の実用計算を行ったコンピュータに対して与えられるゴードンベル賞を過去1995,1996,1999,2000,2001,2003年の6回受賞している。最新のGRAPE-6は,64テラフロップスの計算速度である.GRAPE-1からGRAPE-6までは,演算器間の接続が問題の方程式に従って固定化されていたため,非常に狭い応用分野でしか利用することができなかったことに対し,GRAPE-DRでは演算器間を可変接続することが可能なため,汎用に用いることが可能である. |

| 注6) | GRAPE-DRでは,プロセッサ間を直接パイプライン・ネットワークで結合し,プロセッサ間で直接演算データを渡すため,フォンノイマン計算機に見られるメモリアクセスボトルネックを回避することが可能である。命令の実行制御はプロセッサ間のデータ移動をコンパイラ等により静的に管理するスタティック・データフロー方式を用いている. |

| 注7) | データレゼボワールは,本研究開発担当者である平木,稲葉らにより2001年から2004年に実施された科学技術振興調整費プロジェクト「科学技術研究向け超高速ネットワーク利用基盤の整備」により開発された,データの分散共有システムであり,日米間のディスク間データ共有を超高速で実現することに対し,スーパーコンピューティング国際会議併設のバンド幅チャレンジにおいて,2002年,2003年と連続受賞した. |

3.GRAPE-DR上で実行する科学技術計算

超高速な科学技術用計算システムを研究開発する目的は,ベンチマークプログラムで高い数値を出すことではなく,科学技術としての意義のある計算結果を達成することにある.GRAPE-DRプロジェクトでは,(1)重力多体系シミュレーション,(2) SPH(Smoothed Particle Hydrodynamics) によるグリッドレス流体計算,(3)分子動力学計算,(4) 境界要素法計算,(5) ゲノムのシーケンスマッチング,(6) 質量分析データに対する高次データ検索,(7) ゲノムデータベースに対するグラフマッチングを用いた機能探索の7分野において,当該分野における研究者を分担者として,ソフトウェア開発を実施し,科学技術的に意義のある計算結果を出す予定である.

参考図1 GRAPE-DRの実装方法

参考図2 GRAPE-DR内部構成